GAMES Webinar 2024 – 349期(多模态大模型视角下的人物动作与交互) | 洪方舟(南洋理工大学),敖腾隆(北京大学)

【GAMES Webinar 2024-349期】(模拟与动画专题-多模态大模型视角下的人物动作与交互)

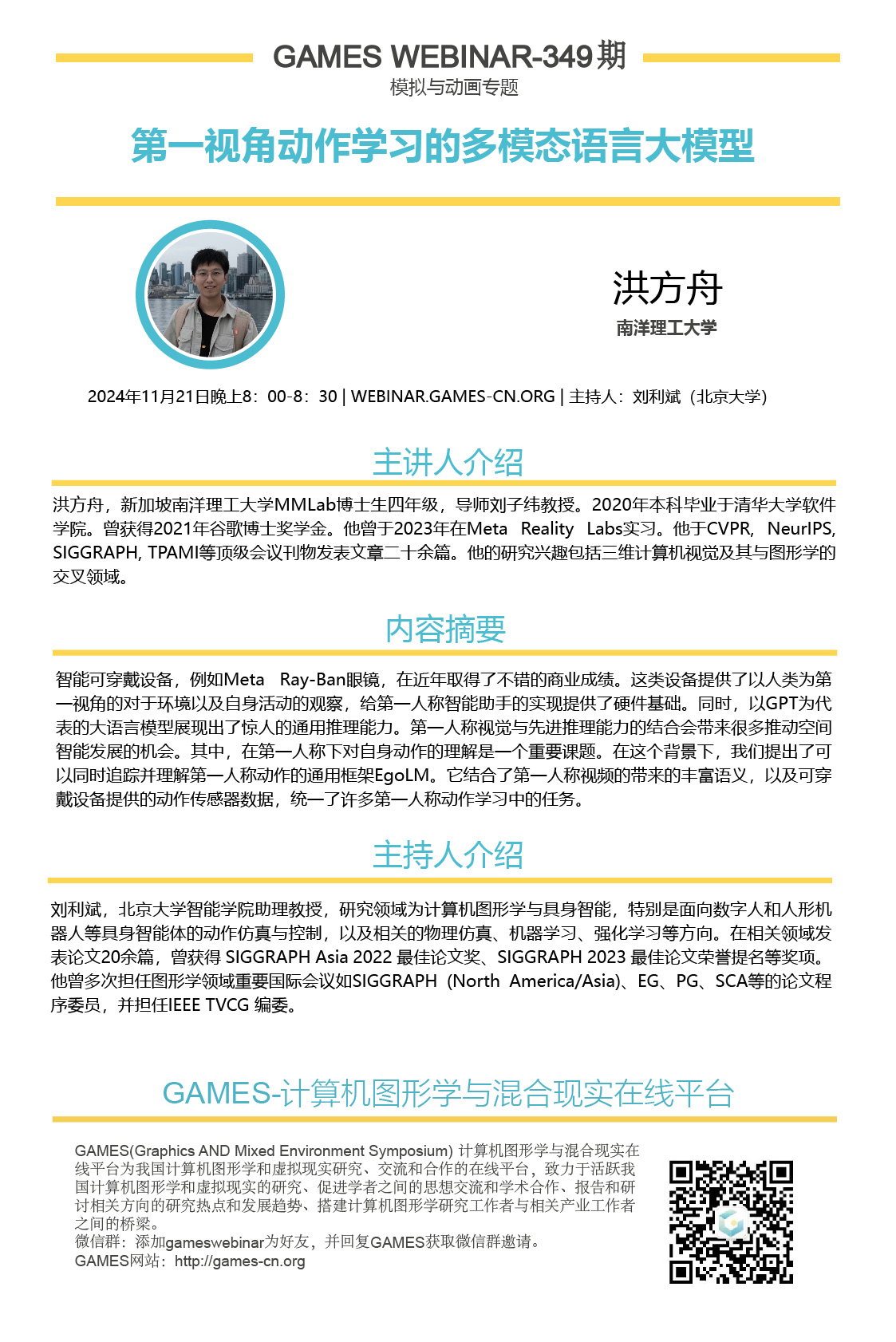

报告嘉宾:洪方舟(南洋理工大学)

报告时间:2024年11月21号星期四晚上8:00-8:30(北京时间)

报告题目:第一视角动作学习的多模态语言大模型

报告摘要:

智能可穿戴设备,例如Meta Ray-Ban眼镜,在近年取得了不错的商业成绩。这类设备提供了以人类为第一视角的对于环境以及自身活动的观察,给第一人称智能助手的实现提供了硬件基础。同时,以GPT为代表的大语言模型展现出了惊人的通用推理能力。第一人称视觉与先进推理能力的结合会带来很多推动空间智能发展的机会。其中,在第一人称下对自身动作的理解是一个重要课题。在这个背景下,我们提出了可以同时追踪并理解第一人称动作的通用框架EgoLM。它结合了第一人称视频的带来的丰富语义,以及可穿戴设备提供的动作传感器数据,统一了许多第一人称动作学习中的任务。

讲者简介:

洪方舟,新加坡南洋理工大学MMLab博士生四年级,导师刘子纬教授。2020年本科毕业于清华大学软件学院。曾获得2021年谷歌博士奖学金。他曾于2023年在Meta Reality Labs实习。他于CVPR, NeurIPS, SIGGRAPH, TPAMI等顶级会议刊物发表文章二十余篇。他的研究兴趣包括三维计算机视觉及其与图形学的交叉领域。

讲者主页:http://hongfz16.github.io

报告嘉宾:敖腾隆(北京大学)

报告时间:2024年11月21号星期五晚上8:30-8:50(北京时间)

报告题目:多模态理解与生成的统一:以“Humanoid Agent”为例

报告摘要:

以语言(language)为代理,视觉(vision)理解模型(VLM – Vision Language Model)和生成模型(T2I – Text-to-image Model)均取得显著进展。近期,以Google Gemini和OpenAI GPT-4o为代表的项目正试图将多模态的“理解(understanding)”与“生成(generation)”统一进行联合建模。本次报告以技术播客“body of Her: A Preliminary Study on End-to-End Humanoid Agent” (https://aubrey-ao.github.io/BodyOfHer/) 为主,从可实时的、全双工的、以视频和语音进行交互的humanoid agent为切入点,讨论多模态理解与生成统一所面临的具体挑战和当前进展。

讲者简介:

敖腾隆,北京大学博士生,导师刘利斌老师。本科毕业于清华大学电子系。曾获SIGGRAPH (Asia) 22 最佳论文奖,SIGGRAPH (NA) 23 最佳论文荣誉提名。他的研究兴趣包括多模态建模。

讲者主页:https://zihan.me/

主持人简介:

刘利斌,北京大学智能学院助理教授,研究领域为计算机图形学与具身智能,特别是面向数字人和人形机器人等具身智能体的动作仿真与控制,以及相关的物理仿真、机器学习、强化学习等方向。在相关领域发表论文20余篇,曾获得 SIGGRAPH Asia 2022 最佳论文奖、SIGGRAPH 2023 最佳论文荣誉提名等奖项。他曾多次担任图形学领域重要国际会议如SIGGRAPH (North America/Asia)、EG、PG、SCA等的论文程序委员,并担任IEEE TVCG 编委。

GAMES主页的“使用教程”中有 “如何观看GAMES Webinar直播?”及“如何加入GAMES微信群?”的信息;

GAMES主页的“资源分享”有往届的直播讲座的视频及PPT等。

观看直播的链接:https://live.bilibili.com/h5/24617282